« La protection des enfants en ligne est un combat de longue haleine, comparable à celui mené depuis des décennies contre le tabac, l’alcool ou d’autres drogues. »

Charel Schmit

Après plus de vingt ans de stratégies pour un « Internet plus sûr pour les enfants », essentiellement centrées sur la sensibilisation, il est plus que temps de changer de cap. Ce changement de cap suppose notamment de proposer systématiquement aux enfants davantage d’offres d’activités analogues et alternatives – culture, sport, engagement associatif, espaces de rencontre – afin que le temps libéré des écrans puisse se transformer en expériences positives. En cohérence avec le principe rappelé récemment par la Commission européenne – selon lequel ce qui est illégal hors ligne doit l’être tout autant en ligne[1] –, l’OKAJU plaide, depuis 2024, pour un véritable « package » de protection des enfants contre les violences et autres préjudices en milieu numérique, inspiré de la prévention en santé publique (prévention primaire, secondaire, tertiaire). Ce paquet combine un cadre légal ambitieux (instauration d’un âge minimum légal pour l’exposition aux écrans, la possession de smartphones et d’appareils connectés, l’accès autonome à Internet et aux réseaux sociaux (sans supervision), obligations de vérification d’âge, responsabilité pour les services en ligne), l’intégration du principe de « sécurité dès la conception » (safety by design) par les acteurs technologiques, ainsi que la responsabilisation conjointe de l’État, des plateformes et des adultes (renforcement de BEE SECURE, meilleure coordination protection de l’enfance/cybersécurité, limitation du temps d’écran, éducation aux médias et soutien à la parentalité numérique).

D’un point de vue fondé sur les droits de l’enfant, le droit à la protection ne saurait toutefois être le seul prisme : les enfants ont aussi droit à l’information, à la liberté d’expression et à la participation, y compris dans l’environnement numérique. Ces droits peuvent cependant se réaliser pleinement dans le cadre d’un accès à Internet encadré, progressif et supervisé par des adultes, qui garantit à la fois la participation des enfants et leur protection contre les préjudices les plus graves.

Des portables sécurisés pour enfants (safe phones) existent déjà sur le marché européen et international, mais ne sont pas mis en avant au Luxembourg. Deux études de 2025[2] et 2026[3] montrent que la possession d’un premier smartphone avant 13 ans est associée à une nette dégradation de la santé mentale et physique, de l’adolescence jusqu’au début de l’âge adulte (plus de dépression, troubles du sommeil, obésité, idées suicidaires, agressivité, détachement de la réalité). Tout comme l’OKAJU, l’étude de 2025 recommande une approche de précaution en santé publique similaire à celle de l’alcool ou du tabac. A la lumière de ces études et d’autres études récentes pointant sur les violences et autres préjudices dont sont victimes les enfants dans l’environnement numérique [4], l’OKAJU recommande depuis 2024, une interdiction de possession de smartphones avant 15 ans[5]. Dans ce cadre, l’OKAJU recommande de faire des portables sécurisés pour enfants (safe phones) un élément central de la prévention primaire. Il s’agirait d’appareils limités aux appels et SMS, sans accès à Internet ni aux réseaux sociaux, proposés comme offre standard par les principaux opérateurs luxembourgeois avant l’âge légal de possession d’un smartphone connecté.

Depuis les recommandations du rapport annuel 2024 de l’OKAJU sur la protection des enfants face aux outils connectés, plusieurs avancées notables ont été faites.

Le Règlement européen sur les services numériques (DSA) est désormais pleinement applicable et consacre une responsabilité accrue des plateformes pour le retrait rapide des contenus illicites et la transparence de leurs algorithmes. Le 30 avril 2025, suite à la publication de la recommandation générale de l’OKAJU sur la protection des enfants face à l’industrie pornographique du 11 février 2025, une motion a été déposée par la députée Paulette Lenert (LSAP) au sujet de la protection des mineurs face à l’exposition aux contenus pornographiques en ligne[6]. Celle-ci a été renvoyée en Commission des Médias et des Communications. Le 21 janvier 2026, à la Chambre des Députés, une heure d’actualité du groupe politique DP (à la demande de la députée Mandy Minella) a eu lieu au sujet de l’accès aux réseaux sociaux des jeunes suite à la légifération en Australie introduisant une interdiction aux moins de 16 ans.

Au niveau de la législation nationale, le projet de loi 8625 sur les médias a été déposé le 30 septembre 2025 par Madame la ministre de la Justice Elisabeth Margue ; une proposition de loi sur les sociétés écrans et la responsabilité des entreprises a été déposée par le député Franz Fayot (LSAP) le 2 décembre 2025 ; et la proposition de loi 8690 sur les réseaux sociaux a été déposé par les députés Francine Closener et Ben Polidori (LSAP) le 21 janvier 2026.

Fin 2024, le ministère de l’Education, de l’Enfance et de la Jeunesse (MENJE) a lancé deux campagnes nationales visant à réduire le temps d’écran, à promouvoir des activités physiques/familiales non numériques et à renforcer la protection des enfants dans l’environnement numérique : « Screen-Life-Balance » et « Sécher.digital ». L’interdiction de l’usage du smartphone dans les écoles fondamentales et maisons relais et sa limitation dans le secondaire commencent à produire des effets positifs : davantage d’interactions sociales directes entre élèves, une baisse observée de la violence et du cyberharcèlement, comme l’a souligné le ministre de l’Éducation nationale à la Chambre des Députés le 21 janvier 2026[7].

Légiférer sur l’âge d’accès aux réseaux sociaux serait une avancée, mais constituerait un simple pansement sur une plaie ouverte nécessitant une opération. Les risques majeurs liés à l’usage d’Internet et des appareils connectés par les enfants dépassent largement le seul périmètre des réseaux sociaux. Il convient en outre de rappeler qu’en vertu de l’article 8 du RGPD, pleinement applicable dans l’Union européenne depuis le 25 mai 2018, les moins de 16 ans ne peuvent en principe utiliser des services en ligne tels que les réseaux sociaux qu’avec le consentement vérifiable de leurs parents ou responsables légaux. Autrement dit, le cadre juridique permettant de limiter l’accès des enfants aux réseaux sociaux existe déjà depuis 2018, mais l’OKAJU déplore qu’il n’a pas été mis en œuvre avec la rigueur nécessaire. Avec cette demi-mesure, les enfants continueraient d’évoluer, souvent sans supervision, dans un Internet loin d’être sûr, un lieu de non-droit : exploitation commerciale de leurs données, exposition précoce à la pornographie et au matériel d’abus sexuel d’enfants (CSAM), contenus haineux ou discriminatoires, tentatives de cybergrooming[8], de radicalisation, de sextorsion – notamment via des jeux et plateformes « ludiques » comme Roblox[9] ou Fortnite[10]. Sans compter les sites et forums qui incitent à la violence, la misogynie, l’automutilation, au suicide… et bien d’autres contenus nuisibles. De plus, le phénomène de « brain rot », utilisé pour décrire la fatigue cognitive et la baisse de concentration liées au défilement incessant de contenus courts, ne concerne pas seulement les réseaux sociaux mais l’ensemble des formats numériques conçus pour capter l’attention (flux vidéo, plateformes de streaming, jeux, messageries, etc.). En lien avec l’ « amnésie numérique[11] » et le « popcorn brain[12] », il constitue un danger supplémentaire pour le développement des enfants, en fragilisant l’attention soutenue, la mémoire en profondeur et la capacité à se concentrer.

Enfin, comme le résume Tony Allen, expert mondial de l’« age assurance » et éditeur technique de la norme ISO/IEC 27566, une régulation fondée sur la seule interdiction d’accès ne peut fonctionner que si elle combine cinq dimensions : légitimité morale, réduction de la demande, alternatives hors ligne, capacité de vérification crédible et absence de déplacement vers des espaces plus risqués[13]. Or, aucune de ces conditions n’est aujourd’hui pleinement réunie.

L’intelligence artificielle expose déjà les enfants à de nouveaux risques majeurs, entre autres des applications de « nudification » et de deepfakes ou encore des chatbots/ compagnons IA[14] qui tiennent des propos sexualisés[15] et entretiennent une forte dépendance émotionnelle. A noter que, selon un rapport d’Internet Matters (UK) de 2025, un enfant sur huit utilisant des chatbots d’IA le fait parce qu’il n’a « personne d’autre à qui parler »[16] . Des experts mettent d’ailleurs en garde contre l’émergence d’une génération qui apprend à nouer des liens affectifs avec des entités dépourvues de capacité d’empathie et de soin[17]. Elle soulève aussi des inquiétudes quant à son impact cognitif : un recours systématique à l’IA pour, par exemple, répondre aux questions, faire les devoirs ou générer des contenus risque d’atrophier l’effort intellectuel des enfants, en externalisant toujours davantage leur mémoire et leur capacité de raisonnement. Face à cette réalité, l’OKAJU souligne qu’il est indispensable de mettre en place une régulation ambitieuse et contraignante de ces outils (services, applications, jouets connectés), qui impose par défaut la protection des enfants.Une responsabilité multi-niveaux

Si les enfants restent vulnérables aux abus, à l’exploitation et à la violence en ligne, c’est avant tout parce que les dispositifs qui les entourent – techniques, politiques, financiers, internationaux et familiaux – ne remplissent toujours pas pleinement leur rôle protecteur[18] :

A l’échelle européenne et internationale

[1] Thomas Reignier, porte-parole pour la Commission européenne, a exprimé que via le DSA, l’Europe replace la responsabilité là où elle doit être, sur les plateformes en ligne : “for a very long time big tech platforms were above the law, behaving like they were too big to care. But thanks to our legislation, the wild west is over, at least in Europe. And our principle is clear and simple – what is illegal offline, must be illegal online” : https://www.linkedin.com/posts/thomas-regnier-24a05810b_we-have-recently-seen-many-accusations-against-activity-7424849788833267712-MUgJ/?utm_source=social_share_send&utm_medium=android_app&rcm=ACoAAAmu_VUBooSC0j_xPmWW24-feFqL1YJa5fc&utm_campaign=copy_link

[2] https://www.tandfonline.com/doi/full/10.1080/19452829.2025.2518313

[3] https://pubmed.ncbi.nlm.nih.gov/41324306/

[4] Voir le chapitre C du rapport annuel 2024 de l’OKAJU ainsi que le chapitre sur la protection dans l’environnement numérique du rapport annuel 2025 de l’OKAJU.

[5] Voir le chapitre C du rapport annuel 2024 de l’OKAJU. Voir aussi l’article paru le 13 août 2025 dans Le Monde : « Il faut interdire la vente de smartphones aux moins de 15 ans » alertent les pédiatres Sylvie Dieu Osika et Eric Osika et la psychologue Karine de Leusse dans une tribune au « Monde », https://www.lemonde.fr/idees/article/2025/08/13/il-faut-interdire-la-vente-de-smartphones-aux-moins-de-15-ans_6629035_3232.html

[6] https://wdocs-pub.chd.lu/docs/Motions_Resolutions/Motion_4566/20250513_Dep%C3%B4t.pdf

[7] https://www.chd.lu/lu/seance/3063

[8] Le terme « grooming » est utilisé lorsque quelqu’un (adulte ou non) crée une relation, une confiance et un lien émotionnel avec un enfant ou un jeune dans le but de le manipuler, de l’exploiter et d’en abuser sexuellement. Lorsqu’il y a une telle approche et manipulation pour exercer une emprise sur Internet, on parle de « cybergrooming ».

[9] https://www.roblox.com/

[10] https://www.fortnite.com/

[11] On entend par « amnésie numérique » le fait de ne plus retenir certaines informations (numéros, mots de passe, itinéraires, dates, etc.) parce qu’on les délègue systématiquement à des appareils ou services numériques. C’est une forme de trouble de la mémoire liée à la surutilisation du numérique, qui encourage le cerveau à « lâcher prise » sur ce qu’il pourrait normalement mémoriser.

[12] Le « popcorn brain » désigne un état où le cerveau, sur‑stimulé par un flux continu de contenus numériques, saute sans cesse d’un stimulus à l’autre, rendant la concentration prolongée beaucoup plus difficile.

[13] https://solicab.com/blog/f/does-prohibition-work

[14] Par exemple, voir : https://www.internetmatters.org/hub/press-release/new-report-reveals-how-risky-and-unchecked-ai-chatbots-are-the-new-go-to-for-millions-of-children/

[15] Par exemple, voir : https://www.telegraph.co.uk/business/2025/07/16/ai-girlfriend-musk-app-12-year-olds/

[16] https://www.internetmatters.org/wp-content/uploads/2025/07/Me-Myself-and-AI-Chatbots-Report-_-Internet-Matters.pdf

[17] https://bmjgroup.com/concern-over-growing-use-of-ai-chatbots-to-stave-off-loneliness/

[18] Liste inspirée de celle publiée par l’ONG ChildSafeNet : https://www.linkedin.com/posts/anil-raghuvanshi-84a35715_saferinternetday-saferinternetday-childonlineprotection-activity-7425746385788080128-mZoj/?utm_source=share&utm_medium=member_android&rcm=ACoAAAmu_VUBooSC0j_xPmWW24-feFqL1YJa5fc

[19] https://www.europarl.europa.eu/news/fr/press-room/20251120IPR31496/il-faut-avoir-16-ans-pour-acceder-aux-reseaux-sociaux-selon-les-deputes

[20] Plateforme européenne pour la participation des enfants (2024). Résultats de la consultation avec des enfants sur les systèmes intégrés de protection de l’enfance : https://eu-for-children.europa.eu/system/files/2024-03/ConsultationReport_ICPS_FINAL_08.03.2024.pdf

[21]https://www.europol.europa.eu/cms/sites/default/files/documents/Europol_Innovation_Lab_Facing_Reality_Law_Enforcement_And_The_Challenge_Of_Deepfakes.pdf

L’environnement numérique doit être conçu et régulé conformément aux exigences de la Convention des Nations Unies relative aux droits de l’enfant (CRDE) (protection contre toute violence, principe de précaution).

Avant cet âge, la supervision effective et le contrôle parental doivent être obligatoires.

Par exemple, permettant uniquement la communication et les fonctions basiques (sans navigation Internet, sans accès aux réseaux sociaux, ou à des réseaux non sécurisés).

y compris les contenus – réels, virtuels ou générés par intelligence artificielle – à caractère pornographique ou incestueux, promouvant la violence ou impliquant du matériel d’abus sexuel d’enfants (CSAM) ou dépeignant des majeurs présentés comme des enfants. Interdire explicitement la production, la diffusion et la promotion de ces contenus sur toutes les plateformes et mettre en place des outils techniques de détection et de retrait immédiat, sous la supervision d’autorités compétentes. Prévoir des sanctions fortes et proportionnées en cas de non-respect, conformément aux standards européens et internationaux (DSA, RGPD).

Safer Internet Day (Messages des OKAJU Young Advisors)

Dans le cadre du Safer Internet Day 2026, les jeunes conseillers de l’OKAJU souhaitent partager leurs visions et leurs recommandations pour un internet plus sûr. En tant que génération qui a grandi avec les réseaux sociaux, ils sont conscient(e)s des opportunités mais aussi des dangers du monde numérique.

Based on its 2024 and 2025 annual reports, the Ombudsman for Children and Adolescents (OKAJU) proposes comprehensive, child‑centred recommendations to strengthen protection online, regulate access, prevent

online violence, and ensure coordinated prevention, enforcement, and victim support.

(ENGLISH, PDF)

L’Observation générale n°25 clarifie comment les droits de l’enfant s’appliquent dans l’environnement numérique. Elle souligne que les États doivent garantir un accès sûr, inclusif et équitable aux technologies, tout en protégeant les enfants contre les risques en ligne, notamment la désinformation, l’exploitation et l’usage abusif de leurs données. Elle promeut la participation des enfants, la transparence des acteurs numériques et l’intégration des droits de l’enfant dans toutes les politiques digitales.on, enforcement, and victim support.

Observation générale n°25

L’Observation générale n°25 clarifie comment les droits de l’enfant s’appliquent dans l’environnement numérique. Elle souligne que les États doivent garantir un accès sûr, inclusif et équitable aux technologies, tout en protégeant les enfants contre les risques en ligne, notamment la désinformation, l’exploitation et l’usage abusif de leurs données. Elle promeut la participation des enfants, la transparence des acteurs numériques et l’intégration des droits de l’enfant dans toutes les politiques digitales.on, enforcement, and victim support.

BEE SECURE RADAR 2026

Rapport de l’ANSES (Agence nationale de sécurité sanitaire de l’alimentation, de l’environnement et du travail), publié le 13 janvier 2026 concernant les usages des réseaux sociaux et la santé des adolescents, fruit de 5 ans de travail et de l'analyse de plus de 1 000 études

Vers le rapport

(avril 2024) rédigé par la Commission sur l’exposition des enfants aux écrans installée par le Président de la République française, co présidée par Servane Mouton (neurologue) et Amine Benyamina (psychiatre addictologue), et composée de huit autres membres experts (Bernard, Borst, Desaint, G’sell, Missir, Rolland, Veret, Zolynski)

Vers le PDF

Etude sur le temps d’écran et les approches politiques de l’usage des medias numériques

Vers le rapport

appliquer pleinement le DSA, collaborer au niveau européen, affirmer que la pornographie est un problème de santé publique

combiner prévention, éducation, répression et soutien aux victimes ; renforcer le rôle de l’ALIA pour vérifier l’adéquation

des mesures de protection sur les plateformes de partage de vidéos.

obligation légale de contrôle robuste de l’âge, retrait immédiat des contenus illégaux, interdiction d’érotisation d’enfants, de contenus violents/incestueux, et sanctions sévères ; interdiction des stratégies marketing ciblant ou susceptibles de cibler les enfants ; contrôle effectif de la conformité à la future loi nationale.

vérifications d’identité strictes pour tout uploader, contrôle humain systématique des contenus avant leur publication, usage de technologies de détection (hachage, IA), signalement et retrait immédiat, conservation des preuves, coopération renforcée entre plateformes, autorités et ONG.

reconnaître l’industrie pornographique comme secteur à haut risque, examiner toutela chaîne de production (vérification de l’âge et du consentement, document d’identité, conditions de tournage et de distribution) ; contrôle des entreprises implantées au Luxembourg.

améliorer le mécanisme de plainte BEE SECURE Stopline (suivi, anonymat, efficacité) ; prévoir des fonds de dédommagement et un accès à des soutiens psychologiques et juridiques ; développer l’offre dédiée aux personnes souffrant d’addiction à la pornographie.

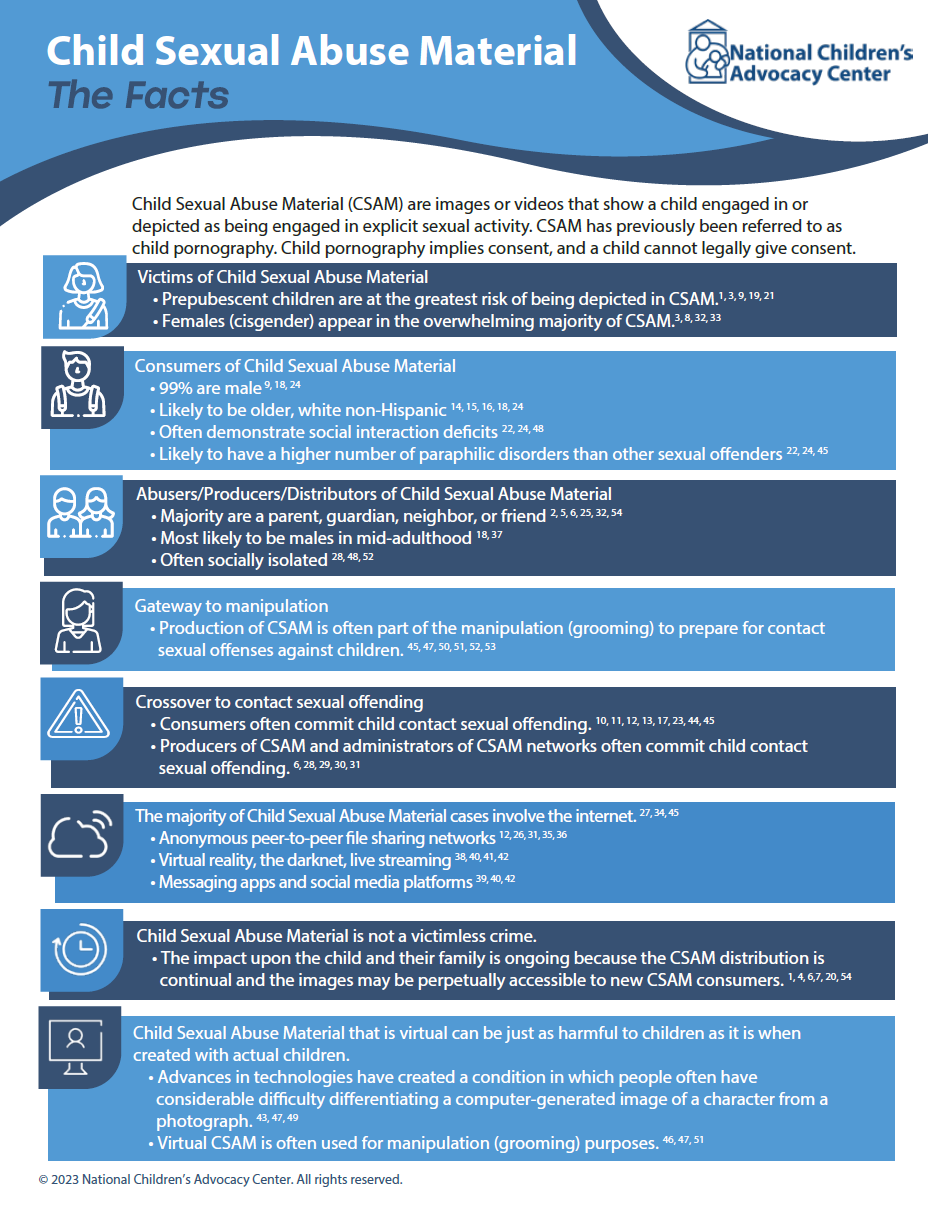

La lutte contre l’exploitation et les abus sexuels à l’encontre des enfants est une priorité incontestable pour l’OKAJU. Elle est au cœur du respect effectif des droits fondamentaux garantis par la Convention des droits de l’enfant. L’essor du matériel d’abus sexuel d’enfants (CSAM), favorisé par le numérique et les réseaux sociaux, représente une menace grave et persistante : chaque image ou vidéo constitue une atteinte directe et renouvelée à la dignité et à l’intégrité des enfants.

Dans ce contexte, l’OKAJU salue la proposition de loi 8643, déposée par Madame la Députée Sam Tanson le 16 octobre 2025, qui vise à garantir le retrait automatique de l’autorité paren-tale et la suspension immédiate des droits de visite et d’hébergement en cas de poursuite ou de condamnation pour des infractions sexuelles ou violentes commises sur des mineurs, même en dehors du cercle familial, renforçant ainsi la protection des enfants contre les abus.

La note suivante vise à éclairer les enjeux spécifiques liés à la production, à la diffusion et à l’impact du CSAM, à rappeler l’obligation de protection pesant sur les institutions et les adultes, et à souligner la nécessité d’une réponse systémique fondée sur l’intérêt supérieur de l’enfant.

pour améliorer les pratiques du système de protection

de l’enfance.

dotée de personnel formé, de moyens techniques dédiés, et bénéficiant de coopérations renforcées avec Europol, INTERPOL et des homologues.

vérification stricte de l’identité des uploader et participants au contenu, utilisation de technologies de détection avancée, mise en place de protocoles clairs (principe de précaution, plans de sécurité individuels), etc.

en réponse à un risque avéré, documenté et mesurable.

Child Sexual Abuse Material (CSAM) are images or videos that show a child engaged in or depicted as being engaged in explicit sexual activity. CSAM has previously been referred to as child pornography. Child pornography implies consent, and a child cannot legally give consent.

(English, PDF)

Une traduction en français est disponible dans le PDF du rapport annuel.

Ombudsman fir Kanner a Jugendlecher

Maison des Droits de l’homme

65, route d’Arlon

L-1140 Luxembourg

La protection des enfants en environnement numérique

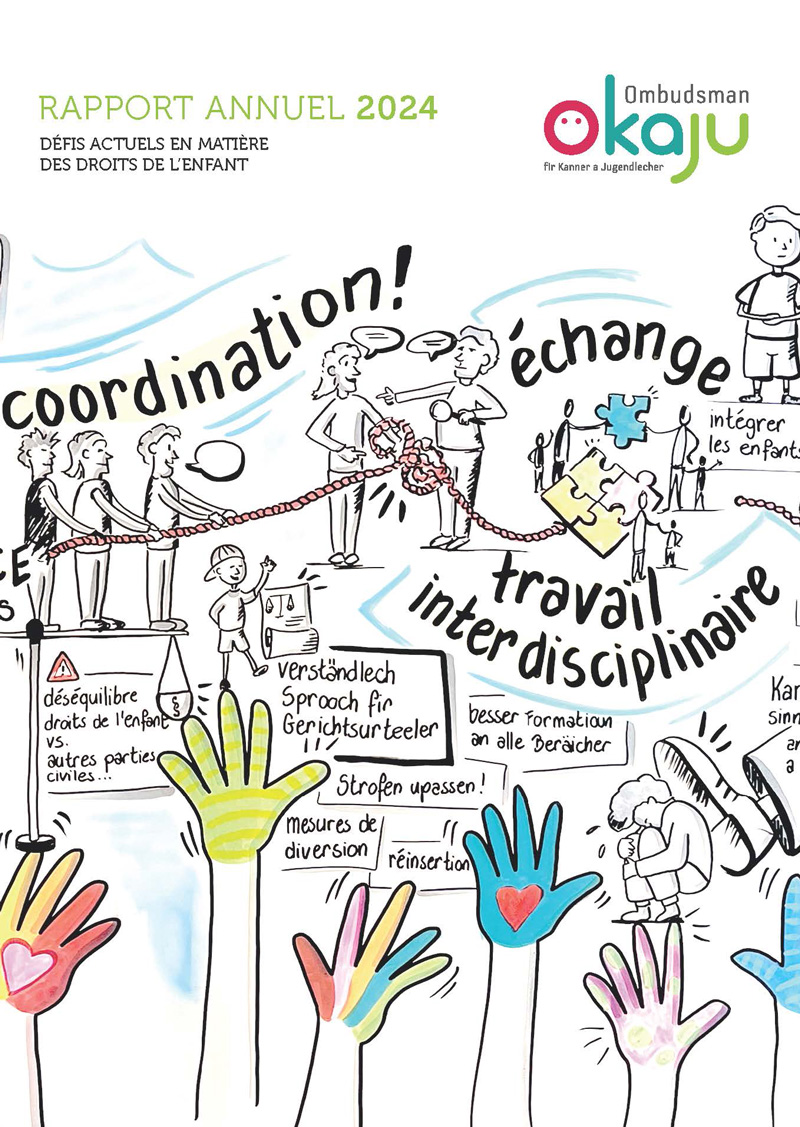

Lorem ipsum dolor sit amet, consectetur adipiscing elit. Ut elit tellus, luctus nec ullamcorper mattis, pulvinar dapibus leo.